AI画图 stable-diffusion_webui on colab

显卡配置

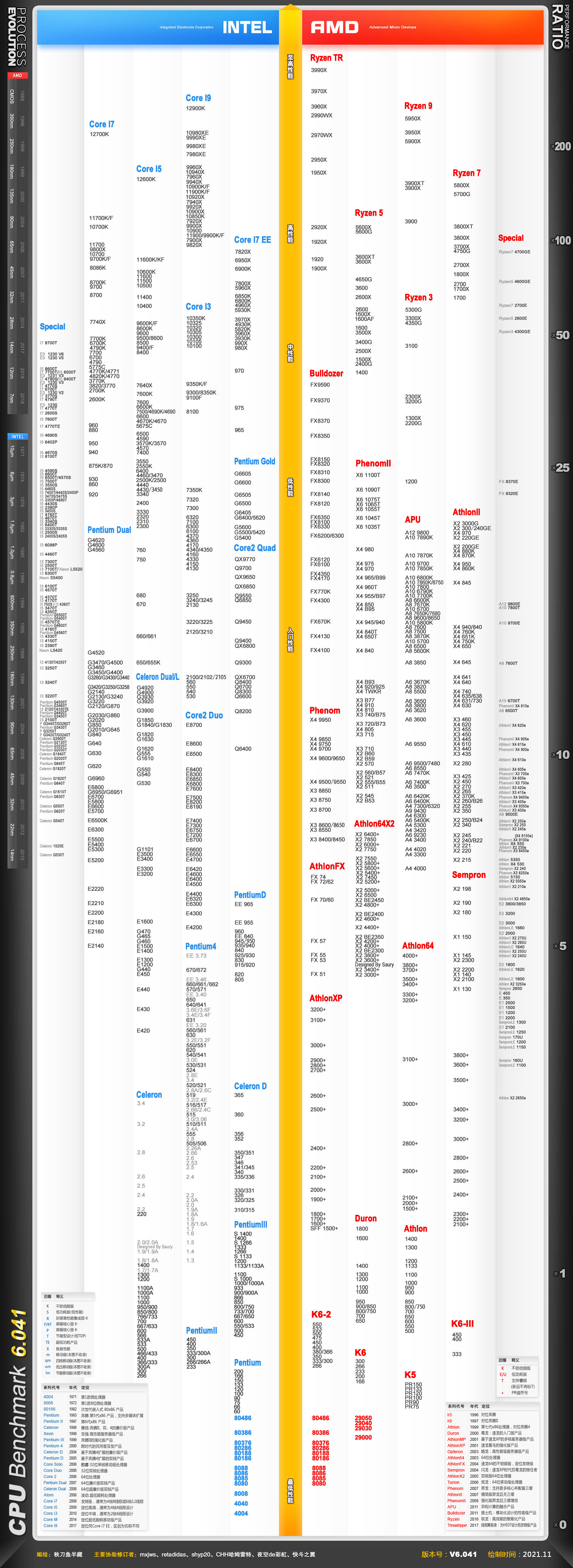

推荐:gtx2060s,内存16g,cpu 8t

手上没显卡2060s最有性价比

手上有显卡,建议p40

软件

Win/Linux

python: 3.10.6(兼容性最好)

N卡cuda

A卡ore(不建议)

网络环境要求访问GitHub

1.git

apt install git

yum install git

win(本文以win为例)

https://git-scm.com/download/win

默认即可

2.python

https://www.python.org/ftp/python/3.10.6/python-3.10.6-amd64.exe

安装过程中应该有选项自动加入path,如没有请手动将python目录添加到path,scrits也要配置进去

3.PyTorch

https://pytorch.org/

cuda11.8以下选11.7,12选择11.8

CPU也可以

复制上面那串命令,粘贴到cmd回车运行,如果前面没有配置scrits,pip将不能使用。

4.搬仓库

选取一个你要放置主程序的目录,右键git bash here

国内可以使用ghproxy加速

5.安装

国内建议修改launch.py

将其中的https://github.com替换成https://ghproxy.com/https://github.com

创建一个虚拟环境

python -m venv .\venv

cd .\venv\Scripts

执行activate.bat

(Linux需要source activate)

国内切换pip源为阿里云

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

返回主目录开始安装依赖

安装成功后退出

开始修改

webui-user.bat

Linux修改webui-user.sh

找到#export BLIP_COMMIT_HASH=""

修改为export BLIP_COMMIT_HASH="--medvram --autolaunch --xformers"

打开的时候分别运行这两个就行

win→webui-user.bat

Linux→webui-user.sh

参数引用b站

没有模型sdwebui可能会启动不了,建议下个ChilloutMix备用

https://civitai.com/models/6424/chilloutmix

下好的模型放在stable-diffusion-webui\models\Stable-diffusion

软件部署:

stable-diffusion不再解释,当下火热的AI画图项目

Colab 是谷歌提供的一种托管式 Jupyter 笔记本服务,只需要知道可以白piao他家的gpu即可。

准备工作

Windows+chromium内核浏览器

因为是谷歌的服务,所以自行配置好网络环境,保正能上谷歌即可。

【注意】断开后Colab将不能运行

提前登录谷歌账号;GitHub账号;GoogleDrive

提前下载

https://huggingface.co/stabilityai/sd-vae-ft-mse-original/blob/main/vae-ft-mse-840000-ema-pruned.ckpt

将其上传至GoogleDrive根目录(最好复制一份作为备份)

收藏并以GitHub登录https://civitai.com/

以便后续使用(开启NSFW,找提示词等)

stable-diffusion_webui使用的是这个项目【以下简称SDwebui】

https://github.com/camenduru/stable-diffusion-webui-colab

个人现在使用的是这个

https://colab.research.google.com/github/camenduru/stable-diffusion-webui-colab/blob/main/stable/stable_diffusion_v2_1_webui_colab.ipynb

准备工作完毕,开始搭建环境

打开colab(上面的那个链接)和civitai

此时应该是这样的,不要着急运行,点左边的文件夹打开

接着点上面的装载谷歌云端硬盘

将滑块(有两层,最外层)拉到最下方,点上移单元格,然后执行![]()

执行后会弹出一个验证,连接到谷歌云盘。

验证后点文件下面的刷新按钮(不是刷新网页)

等待片刻,就会出现drive的目录,将开始上传的VAE拖拽到SD的VAE目录(移动)

最后点击运行这个单元格开始安装相关依赖和程序

经过漫长的等待,最后会生成几个网址,指向本次搭的SD服务

[当然是建议https]

开始使用

点开刚生成的任意一个链接(不建议多人使用)

[搭建成功应该是这样]

先加载SD VAE,刚我们从谷歌盘拉过来的那个。

【注意】没有的话点旁边的刷新

接着我们打开civitai,找个喜欢的模型,比如ChilloutMix,如果你看不到说明没有登录,里面含有NSFW内容,默认是不给显示的。

复制这个名称回到SDwebui,在Civitai按照图示依次完成搜索到下载,注意中间有进度条要等待,开始下载后在colab后台能看到进度。

(这个模型看你自己需要来决定是否备份到谷歌云盘,停止程序后可以使用copy命令完成备份,在我看来谷歌盘要快得多)

又是经过漫长的等待,回到SDwebui的主界面,与配置SD VAE一样,载入下载好的主模型(checkpoint)

如此一来就可以开始我们的绘图之旅

开始绘图

先熟悉主界面的几个功能

txt2img 文生图

img2img 图生图,好处是有一定的可控性,比如色彩比如构图

image Browser 图片浏览(已经完成的图片)

Extras 通常执行批量ai放大

-------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

CivitAi 模型站

Hugging Face 需要token,可以直接从上面下开头那个VAE

-------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

Setting 设置

Extensions 插件

Train 训练

流程:

打开CivitAi找喜欢的模型,载入到SDwebui中,紧接着在模型下方的展示页面里,物色几张好看的图,点入右下角找提示词

将刚刚的Prompt和Negative Prompt填入框中,Prompt为想要的关键词,Negative Prompt为不想要的关键词。

根据需要选择适当的method,steps,CFG以及尺寸。

这里注意尺寸越大速度越慢,并且后续会执行ai放大,建议设置为1500以内,需要快速出图的,请设置在1000以内,并控制步数在20左右。

最后点击generate生成就可以了

同样的,可以在colab后台看到进度

完成后,继续点击send to img2img进行放大

依次在底部script选择SD upscale,根据需要调整下方的Scale Factor(2即为两倍放大)

Upscaler建议勾选R-ESRGAN 4x+,其余参数请自行尝试。

上方的Denoising strength建议根据模型调整至适当的值,有说法值越高,程序参与改动越多,比如破图。

最后点击生成,等待结果

【非常重要】过高的尺寸将大幅提升计算时间,甚至造成绘图失败

Lora的使用

简单解释下,一般几种模型可以这么理解:checkpoint为主模型,决定整张图的艺术风格,VAE相当于配色影响图片质感。而Lora则可以当作辅助模型,它可以是雷电将军,也可以是八重樱,可以是奥特曼,也可以是孙悟空,记录了素材的特征,根据这些特征以checkpoint的艺术风格生成图片。

并且Lora是可以自己训练的,难度不高。

同样,我们需要去CivitAi找喜欢的Lora模型,复制名称回到SDwebui,和checkpoint一样,务必在搜索之前勾选Lora

回到主界面,在下方点开Additional Networks,刷新模型,直接第一个模型下拉找到刚下好的Lora(没有说明你没下好),选中后务必勾选Enable。

如法炮制,仅供参考

| 没有了解过ai画图的可以看看前面的帖子。 工欲善其事必先利其器,一些常用的模型建议提前下好。 colab白piao用户更是如此,强烈建议将常用模型放谷歌盘,C站H站高峰期速度不稳定,往往等上半小时下载。 建议先用huggingface下载,使用结束后备份到谷歌盘,下次使用直接拖过来。  这里推几个常用的模型: vae-ft-mse-840000-ema-pruned.ckpt chilloutmix(据说7g版更好?) 饭特稀 国风3(可配汉服) KoreanStyle2.5D counterfeit(动画) Lora japaneseDollLikeness koreanDollLikeness(必备) taiwanDollLikeness fashionGirl 20d 各种pov(你懂的) 为什么画不出想要的效果,其实提示词差别不大,关键在于《主题》,合适的Lora更容易生成想要的内容。  以这张图为例,单用chilloutmix是比较难出这样的效果(尤其容貌) 这里还引用了koreanDollLikeness和taiwanDollLikeness两个Lora 根据提示词去找即可 提示词不是什么魔法咒语 应该灵活变通,而不是生搬硬套,建议花点时间看看上面写了什么,根据自己需要去增删。 非特殊内容,强烈建议在提示词的前方添加“solo”这样的关键词,避免出现多个人物——往往还是画坏的。 负面描述 个人倾向于越多越好,因为可以通用,有价值好好写个模板。 其中对肢体的描述尤为重要 多画点你就知道,最后NSFW灵活使用。 效率!! AI画图终究还是开盲盒 可千万不要一个提示词画一次,看到好的又想换。 记住:单抽比不过十连  在不爆显存的情况下,调好整好尺寸,设置一个合适的《批次》 sdwebui会根据你设定的批次开始批量跑——12就是生成12张 并且,没有特殊情况下,绘图步数不要超过30。 采样方法尽可能使用DPM++ 2M Karras而不是SDE(很慢) 当然具体情况以模型作者建议参数为准。 画完后使用图生图→图像批处理→配置好输入输出目录→调整参数即可批量出图  重绘幅度尽量不要超0.3  记得处理完后删掉输入文件夹内的临时图片 默认输出的图片会生成一张jpg和png,jpg的exif会保留这张图的提示词,有需要可以保留。 完成这个流程后再进行下一轮跑图。 |

扫描二维码推送至手机访问。

版权声明:本文由Virtualization esxi pve unRaid vmware synology nas docker blog发布,如需转载请注明出处。